1. Am Anfang steht das Training

Das Training moderner Künstlicher Intelligenz (KI), insbesondere großer Sprachmodelle, erfordert sehr große Mengen maschinenlesbarer Texte, um menschenähnliche Ergebnisse zu erzielen. Die Nutzung vorhandener Daten zu Trainingszwecken von KI-Modellen, insbesondere mit personenbezogenen Daten, ist rechtlich nicht unproblematisch.1

Gleichzeitig stellt sich auch aus technischer Sicht die Frage nach der Datenqualität, dem notwendigen Data Cleansing, der Repräsentativität und der Aktualität der Trainingsdaten. Diese Faktoren bestimmen maßgeblich die Leistungsfähigkeit eines Modells und beeinflussen Verzerrungen, sogenannte Bias. Zudem können bei Vorhersagen (Prediction) Abweichungen auftreten, wenn das Training der Modelle ausschließlich mit historischen Mustern (Patterns) stattfindet, die nicht ausreichend bereinigt sind. Unscharf Ergebnisse entstehen, wenn Korrelationen in den Daten nicht klar erkannt werden und die zugrunde liegenden KPIs für die Optimierung nicht eindeutig definiert sind.

2. Integrität und Vertraulichkeit

Neben der Zweckbindung ist im Rahmen der Verarbeitung personenbezogener Daten, deren Integrität und Vertraulichkeit zu gewährleisten. Die Datenverarbeitung muss daher unter anderem eine angemessene Sicherheit der personenbezogenen Daten gewährleisten, einschließlich Schutz vor unbefugter oder unrechtmäßiger Verarbeitung. Weiterhin ist der sogenannte Grundsatz der Datenminimierung zu beachten. Personenbezogene Daten müssen dem Zweck angemessen und erheblich sowie auf das für die Zwecke der Verarbeitung notwendige Maß beschränkt sein, d. h. es dürfen nur die Daten verarbeitet werden, zur Erreichung des zugrundliegenden Zwecks erforderlich sind.

Technisch bedeutet dies: Je geringer die Datenbewegung, desto niedriger das Risiko von Datenlecks oder Angriffen. Hier setzt Federated Learning an.

KI-System im medizinischen Bereich

Wird beispielsweise ein KI-System im medizinischen Bereich zur Bilderkennung trainiert und dabei Patientendaten verschiedener Kliniken verwendet, muss sichergestellt werden, dass keine unbefugten Personen Zugriff auf diese sensiblen Gesundheitsdaten erhalten. Datenschutzrisiken lassen sich zusätzlich durch eine Minimierung der Datenübertragung senken.

Medizinische Daten zählen zu den sensibelsten Informationen überhaupt. Sie unterliegen dem höchsten Schutzniveau nach DSGVO und AI-Act sowie branchenspezifischen Vorgaben, wie GxP (z. B. GMP, GCP) und internationalen Standards wie FDA 21 CFR Part 11 oder EMA-Richtlinien. Angriffe auf solche Daten sind nicht nur rechtlich kritisch, sondern können unmittelbar die Patientensicherheit gefährden. Daher müssen KI-Systeme in der Medizin validiert (CSV, CSA), auditierbar und revisionssicher betrieben werden. Der Betrieb geht mit strengen Maßnahmen, wie Ende-zu-Ende-Verschlüsselung, Zugriffsbeschränkungen, Audit-Logs und kontinuierlichem Monitoring einher.

3. Federated Learning (FL)

Der vom European Data Protection Supervisor (EDPS) und der spanischen Datenschutzbehörde (AEPD) diskutierte Ansatz ist das sogenannte Federated Learning (föderiertes Lernen). Dabei verbleiben die Daten dezentral bei den jeweiligen Einrichtungen. Eine zentrale Sammlung der Daten findet nicht statt.2

Was wird unter “Federated Learning” verstanden?

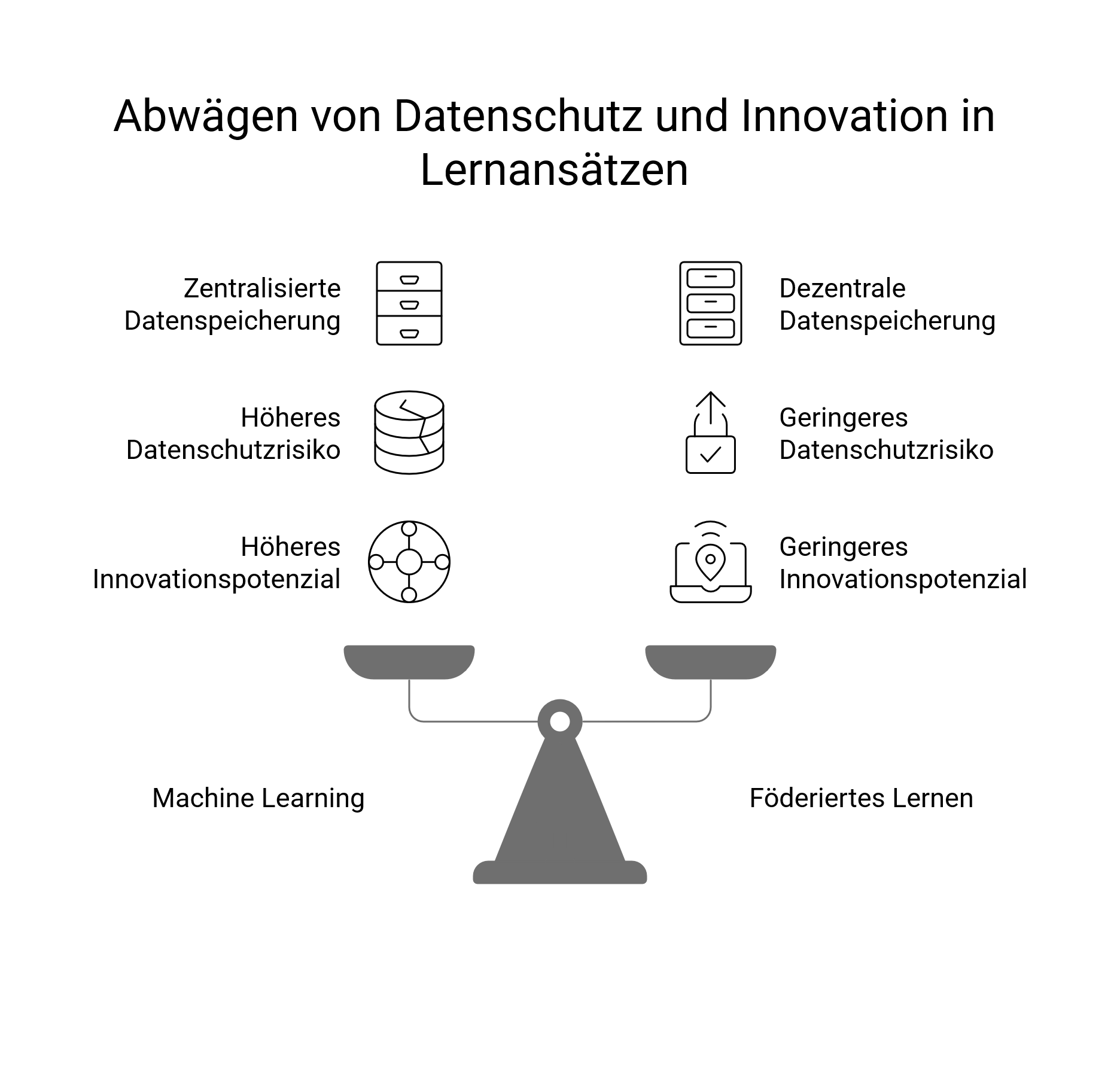

Anders als beim zentralisierten Machine Learning, bei dem alle Daten an einem Ort gesammelt werden, ermöglicht Federated Learning mehreren Datenquellen, ein gemeinsames Modell zu trainieren, während die Rohdaten lokal auf den jeweiligen Geräten verbleiben. Lediglich die Modell-Updates (z. B. Parameter, Gradienten) werden geteilt.

Rohdaten bleiben wo sie sind – Compute to data

So trainiert eine Klinik mit den eigenen Patientendaten unmittelbar nur ihr eigenes Modell, etwa auf den eigenen Geräten oder den eigenen Server. Geteilt werden dann nur die abstrakten Lernergebnisse (Parameter, Gradienten, …), also die mathematische Anpassungen, die das Modell lokal gelernt hat.

So können Modelle trainiert werden, während die Daten dezentral gehalten werden.

Der Austausch kann dabei von Gerät zu Gerät erfolgen oder über einen Server zentral getauscht werden.

KI lernt dazu aber die Daten landen nicht irgendwo zentral

Mit einem solchen dezentralen Ansatz könnte sichergestellt werden, dass personenbezogene Daten unter der Kontrolle des Verantwortlichen, hier der Klinik, bleibt und nicht an externe Parteien und andere Einrichtungen weitergegeben werden müssten, ohne innovationsverhindernd zu sein. Ein weiterer Vorteil, den der Verzicht eines großen Datenspeichers mit sich bringt, ist in ein geringeres Risiko im Falle eines Datenlecks. Allerdings erhöht sich durch die Vielzahl dezentraler Speicherorte auch die Angriffsfläche für potenzielle Angreifer.

Zudem könnte das Einwilligungsmanagement transparenter gestaltet werden, da leicht verständlich ist, wo die Daten verarbeitet werden.

In der Praxis wird Federated Learning heute u. a. bereits bei Smartphones (z. B. Google Gboard), Wearables (z. B. SmartWatches), im Bankensektor und in der Medizin erprobt. Es gilt als State-of-the-Art für Privacy-Preserving AI.

4. Technische Herausforderungen

Obwohl Federated Learning aus Datenschutzsicht viele Vorteile bietet, bestehen weiterhin technische Herausforderungen bei der praktischen Umsetzung.

Kann man trotzdem Informationen über die Modell-Updates herausziehen?

Die geteilten Modell-Updates sind nicht zwangsläufig anonym. Sie können Informationen enthalten, die Rückschlüsse auf die Trainingsdaten ermöglichen (sogenannte „Membership Inference Attacks“3).

Weiterhin können die Daten der einzelnen Modell-Updates unterschiedlich, verzerrt oder fehlerhaft sein, so dass sich daraus für das Gesamt-KI-System Probleme im Hinblick auf die Datenqualität ergeben können.

Auch die Synchronisierung von Updates bei unterschiedlichen Bandbreiten, Endgeräten oder Servern ist aktuell eine offene technische Herausforderung.

Maßnahmen

Um diesen Risiken zu begegnen, empfiehlt sich der Einsatz von Sicherheitsmaßnahmen, wie Verschlüsselung der gespeicherten Daten, Secure Multi-Party Computation oder Secure Aggregation. Diese kryptografischen Methoden ermöglichen Berechnungen auf verteilten Daten, ohne dass einzelne Datenpunkte offengelegt werden. Trusted Execution Environments (TEE) können eine geschützte Ausführungsumgebung bieten, während Differential Privacy durch gezielte Störsignale das Risiko einer Identifizierbarkeit einzelner Personen weiter senkt.

Zusätzlich können spezialisierte Monitoring-Tools eingesetzt werden, um Modellintegrität und Qualitätskontrollen sicherzustellen. Dazu zählen, zum Beispiel Hashing- und Secure-Aggregation-Frameworks wieTensorFlow Federated, OpenMined, PySyft, etc. zur Manipulationserkennung, Anomaly-Detection-Tools wie PyOD, MLflow, etc. zur Identifikation fehlerhafter Updates sowie Fairness- und Bias-Monitoring (z. B. IBM AI Fairness 360). Durch Logging- und Versionierungssysteme wie MLflow oder Weights & Biases lassen sich föderierte Trainingsprozesse zudem transparent und revisionssicher nachvollziehen.

Hinweis: In produktiven Föderationsprojekten (Medizin, Banken, Automotive) wird oft eine Kombination eingesetzt, ergänzt durch eigene Security-/Audit-Layer (z. B. Blockchain-Audit-Trails, Differential Privacy).

5. Fazit

Insgesamt stellt Federated Learning kein Allheilmittel dar, bietet aber gegenüber zentralisiertem Machine Learning deutliche Vorteile für den Datenschutz. Herausforderungen, wie Datenqualität und technische Komplexität, müssen jedoch adressiert und durch geeignete Schutzmaßnahmen flankiert werden.

Richtig umgesetzt kann es ein Schlüsselbaustein sein, um KI-gestützte Innovationen mit den Anforderungen an Datenschutz, Datensouveränität und Sicherheit in Einklang zu bringen – insbesondere in sensiblen Bereichen wie Medizin, Finanzwesen oder kritischer Infrastruktur.

Federated Learning ist ein State-of-the-Art-Ansatz, um KI-Modelle datenschutzfreundlich zu trainieren, ohne Rohdaten zu bewegen:

- In der Forschung gilt es als moderner Ansatz für Privacy-Preserving AI.

- In der Industrie ist es eher „auf dem Weg dahin“. Es existieren viele Pilotprojekte, aber auch noch technische Hürden (z. B. Datenqualität, Angriffe auf Modell-Updates, Standardisierung).

- Wird durch ISO 42001 (KI-Management) und den AI-Act indirekt relevanter, weil es Datenschutz- und Souveränitätsfragen elegant adressiert.

Es ist nicht „die Lösung für alles“, aber gerade in Europa hochaktuell, weil es die rechtlichen Vorgaben bei der technischen Entwicklung vereinen kann.

Bei Interesse, Fragen und Austausch zu dem Thema oder wenn das für Ihr KI-Modell als Lösung interessant ist, kommen Sie gerne auf uns zu und melden sich hier.

- vgl. How much data from the public Internet is used for training LLMs? | by Michael Humor | GoPenAI ↩︎

- s. https://www.edps.europa.eu/system/files/2025-06/techdispatch_federated-learning_en.pdf ↩︎

- vgl. https://arxiv.org/abs/2103.07853 ↩︎

AUTOREN

Sascha Scheffler ist diplomierter Maschinenbauingenieur und Experte für digitale Transformation. Er ist zertifizierter Lean Administration Expert, hat einen Master in Business with AI (MBAI®) und ist derzeit in Ausbildung zum AI Integration Expert.

Matthias Rosa ist Rechtsanwalt und Fachanwalt für IT-Recht und schwerpunktmäßig im Datenschutz- und KI-Recht tätig.